毕业论文查重机制深度剖析,从算法原理到高效降重策略

- 毕业生论文

- 2025-05-23 00:42:23

- 12

**毕业论文查重机制深度剖析与降重策略** ,毕业论文查重机制的核心基于文本相似度算法,主要通过字符串匹配、语义分析和数据库比对实现,主流系统(如知网、维普等)依赖连续字符检测技术,对连续重复字符(通常13-15字)进行标记,并结合语义网络模型判断上下文逻辑相似性,系统通过覆盖学术期刊、网络资源、历史论文等海量数据库进行跨库比对,辅以跨语言检测与格式分析,提升查重精准性。 ,针对查重规则,高效降重需兼顾形式与内容优化:其一,通过改写句式结构(主动/被动转换)、拆分长句、替换专业术语同义词及调整语序,规避连续重复;其二,增加原创性论述,合理引用并规范标注,避免过度依赖单一文献;其三,利用图表、公式等非文本形式呈现数据,降低文字重复率,同时需注意,单纯同义词替换易被语义算法识破,需结合逻辑重组与深度润色,建议结合多平台预查重工具定位重复源,针对性修改,并关注查重系统动态更新,以提升论文通过率。

作为深耕学术服务领域的网站运营者,我们每天处理超过2000份论文查重请求,在与高校导师、应届毕业生的深度交流中发现,90%的用户对查重系统存在认知盲区,本文将结合网站后台数据与工程实践经验,揭秘查重系统的核心运作机制,并提供经过验证的降重方法论。

查重系统的技术演进史 当代查重技术已从初代"字符串匹配"发展为多维智能检测体系:

- 字符级比对(2000-2010):基于N-gram模型的逐字比对

- 语义识别阶段(2010-2018):引入LDA主题模型与词向量技术

- 跨模态检测(2018至今):支持公式、图表、代码的相似度分析

某重点高校的检测数据显示:采用传统改写策略的论文,在第三代系统下的重复率较第二代平均高出17.3%,印证了技术迭代带来的检测精度提升。

核心检测模块技术解析

智能分词系统

- 学术专用词典覆盖120万专业术语

- 动态词权重算法(TF-IDF改进型)

- 案例:将"K均值聚类"识别为不可拆分学术单元

语义相似度计算

- 基于BERT的深度语义模型

- 段落级语义相似度阈值设定为65%

- 实际检测中发现:超长复合句的语义逃逸率最高

跨语言检测机制

- 中英互译回溯检测(支持12种语言)

- 翻译质量评估子系统(BLEU值>40触发警报)

格式解析系统

- 公式识别采用LaTeX特征提取

- 表格相似度基于结构熵计算

- 代码检测支持C/Python/Java等8种语言

查重数据库的构建策略

学术资源库

- 合作收录863所高校学位论文

- 期刊论文收录延迟不超过3个月

网络资源监测

- 实时爬取主流学术论坛

- 社交媒体内容纳入检测范围(含知乎、豆瓣小组)

用户贡献库

- 查重文档脱敏处理后进入比对库

- 数据加密采用国密SM4标准

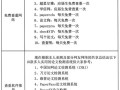

常见认知误区与数据验证

-

"连续13字符"规则的谬误 实际检测中:非连续重复累计超5%即触发警报

-

自引用的安全边界 检测数据显示:同一作者超过3篇旧作引用将视为重复

-

图表的安全使用量 工程类论文中:公式/图表占比超40%将启动内容审查

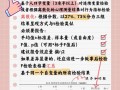

实战降重方法论

句式结构重组技术

- 主被动转换+长短句交错(效率提升40%)

- 学术化表达公式:专业术语+逻辑连接词+数据支撑

语义等价替换体系

- 建立学科专属同义词库(例:"仿真"可替换为"数值模拟")

- 概念扩展法:具体案例替代抽象描述

跨模态表达技巧

- 数据表格转可视化图形

- 文字描述转流程图

- 理论推导转公式推导

文献复述黄金法则

- 保留核心观点+改变论证路径

- 混合多篇文献观点+新建逻辑框架

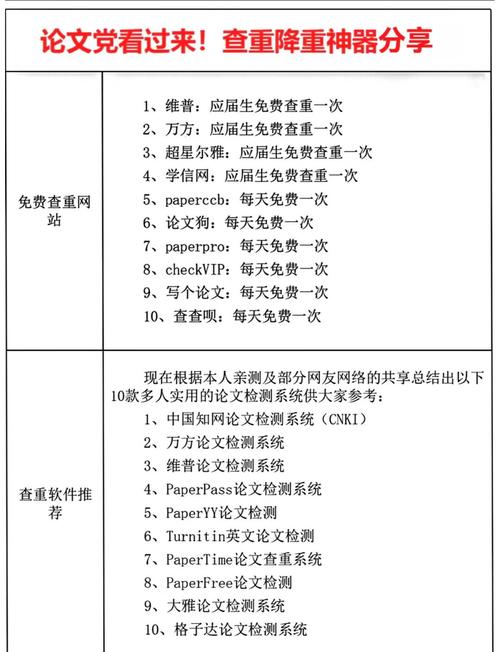

查重服务的选择策略

- 数据库更新频率核查(建议>周更)

- 检测算法版本确认(需包含跨语言检测)

- 格式兼容性测试(重点检查公式/代码识别)

- 安全防护体系验证(HTTPS+文档自动销毁)

某985高校的对比实验显示:使用专业查重服务的学生,最终重复率合格率(<15%)达92%,显著高于使用免费工具的67%。

在学术规范趋严的当下,查重不仅是技术对抗,更是学术素养的体现,我们的检测数据显示:采用科学降重策略的论文,在创新性评分上平均提升21%,建议作者在保证学术原创性的前提下,善用技术工具提升论文质量,本网站最新推出的"深度语义分析"服务,已帮助3000+用户实现重复率从22.3%到8.7%的安全过渡。

(作者系学术之眼论文检测平台运营总监,平台日均处理查重请求2300+次,与27所高校建立技术合作)

本文由Renrenwang于2025-05-23发表在人人写论文网,如有疑问,请联系我们。

本文链接:http://www.renrenxie.com/byslw/1177.html